-

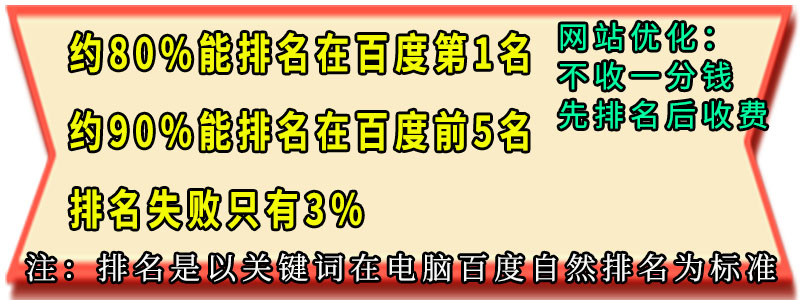

自然排名 点击多少均不要钱哟!

自然排名 点击多少均不要钱哟!

可能会帮您的生意提高几倍,几十倍 -

搜索引擎的蜘蛛抓取页面的一般过程是这样的。

首先,收集待索引网页的url。

搜索引擎的蜘蛛一般分为两类,这前几类的主要工作就是收集网页的中有效的URL。它们的任务是一刻不停地扫描Internet资源,以随时更新其搜索引擎庞大的url列表以供它的**类蜘蛛使用。也就是说,当这一类蜘蛛访问我们网页的时候,并不在于索引我们的网页,而是在寻找网页中的所有有效链接。

关于有的站长在自己的访问日志中发现多个蜘蛛IP爬自己站的情况。

我们常用的搜索引擎每天要处理数以亿计的信息,没有一个大型的搜索引擎公司(GOOGLE或百度之类)不配备上万台服务器来共同执行这个工作,因此搜索引擎都拥有不同的数据中心,也就是说有多个robots来检索你的站是很正常的事情。

不过这也**于前几类蜘蛛,在索引页面的时候,搜索引擎会限制某个特定的数据中心来让专门索引页面的蜘蛛检索你的站。

因此朋友们从服务器访问日志中时常可以看到源自不同IP的蜘蛛,在很短的时间内频繁访问网站。不过千万不要高兴得太早,也许其根本不是在索引你的网页而只是在扫描url。

顺便贴几个百度几个常用的蜘蛛IP

15.220.181.19.

16.159.226.50

17.202.108.11

18.202.108.22

19.202.108.23

20.202.108.249

21.202.108.250

22.61.135.145

23.61.135.146

补充一下,前几类蜘蛛索引时记录的信息主要包括网页的url、更终修改时间等

至于网页的Head信息是前几类蜘蛛来获取还是**类来获取,很多人都有不同的看法,但我还是比较赞成前几类蜘蛛访问时就能索取这个信息!

看看搜索引擎的蜘蛛是如何抓取页面的,欢迎咨询合作。